Hosting

Wykorzystaj content konkurencji do optymalizacji strony

Co znajdziesz w tym artykule:

W artykule podpowiadam jak „zrozumieć” algorytm Google i przygotować skuteczną optymalizację strony, która pozwoli na pozycjonowanie i osiągnięcie lepszych wyników w krótszym czasie.

Celem niemal wszystkich właścicieli serwisów internetowych jest pozyskanie ruchu, a jednymi z najpotężniejszych narzędzi, które pomagają w osiągnięciu tego celu są wyszukiwarki internetowe. W zależności od preferencji i lokalizacji użytkownicy korzystają główne z Google, Bing, Yahoo czy Yandex.

Algorytm oparty o UX oraz AI

Algorytm każdej z liczących się wyszukiwarek uwzględnia nie tylko „suche” czynniki oparte na wartościach liczbowych, ale również doświadczenia użytkownika w oparciu o metryki behawioralne.

Dla każdej branży i obszaru geograficznego – optimum jest inne. Wydaje się zatem, że nie znając konkretnych wartości związanych z metrykami UX u konkurentów – możemy jedynie zgadywać co spełni oczekiwania użytkowników.W rzeczywistości są jednak zmienne, które pozwalają na dość precyzyjne określenie oczekiwań użytkownika. Znając wymagania użytkownika, możemy przewidzieć jego zachowanie i przygotować optymalizację w taki sposób, żeby dać pełną odpowiedź na konkretne zapytanie.

Z podobnym problemem i procesem mają do czynienia wyszukiwarki, które w formacie „real time„, przy każdorazowym wyszukiwaniu frazy starają się dopasować wyniki do potrzeb internauty.

Jak działa wyszukiwarka Google?

Użytkownicy, za pomocą klawiatury lub mikrofonu (wyszukiwanie głosowe) podają zapytanie. Google przeszukuje bazę danych, w której przechowywane są między innymi treści stron internetowych, a następnie odpowiada w formie uporządkowanej listy stron internetowych, posortowanych w kolejności od najbardziej relatywnych.

Najbardziej relatywne to takie, które najlepiej odpowiadają oczekiwaniom userów, które najbardziej kompleksowo rozwiązują problem.

Analiza zachowania użytkownika z wykorzystaniem AI

Na bazie między innymi satysfakcji użytkownika, algorytm wyszukiwarki ocenia czy podana lista wyników była odpowiednia. Każdorazowe wyszukiwanie frazy i zwrócenie wyników wyszukiwania generuje nowy zestaw danych, który posłuży do aktualizacji wyniku jakości dla poszczególnych witryn internetowych.

Dlaczego zatem nie wykorzystać zasobu wiedzy Google w kontekście oczekiwań użytkownika? Znając oczekiwania – jesteśmy w stanie przewidzieć zachowanie i wykorzystać dane nie tylko w procesie pozycjonowania strony internetowej, ale również przy pisaniu treści, a nawet tworzeniu projektu graficznego lub makiety strony www.

Jak wykorzystać AI dla twojej strony

Mając wiedzę na temat czynników i schematów sprawdzających się u konkurencji możesz zastosować podobne elementy na swojej stronie. Na mojej prezentacji na semKRK zostałem zapytany przez jednego z uczestników czy jest jeden złoty środek, który pozwoli skutecznie zoptymalizować stronę. Niestety nie ma, ale korzystając z narzędzia https://surferSEO.com/ możesz sprawdzić i porównać konkurentów z każdej branży i każdego regionu.

Analiza danych za pomocą Surfer

Na podstawie wyników wyszukiwania Google, Surfer dokonuje analizy kilkuset czynników rankingowych i pomaga zidentyfikować te, które mogą mieć znaczenie w obrębie danej branży. W ciągu kilku minut otrzymujesz wynik analizy.

Taka sama analiza realizowana manualnie trwałaby minimum kilkanaście godzin i byłaby obarczona ryzykiem popełnienia błędu, który mógłby zakłócić poprawne odczytanie danych.

Analiza porównawcza pozwala na poznanie oczekiwań użytkownika, wychwycenie wspólnych elementów „must have”. Wśród nich wiele oczywistych jak na przykład:

- obszerność treści,

- ilość plików graficznych (obrazków, wykresów, infografik, itd.),

- ilość odnośników do social media,

- zagęszczenie słów kluczowych,

- ilość nagłówków,

- obszerność akapitów i wiele innych.

Dzięki analizie możemy również zbadać elementy bardziej techniczne:

- ttfb (time to first byte) – czas reakcji serwera,

- czas załadowania się strony,

- ilość tekstu i innych elementów widocznych na ekranie bez przewijania,

- wykorzystanie technologii AMP,

- użycie certyfikatów SSL i inne.

Tego typu czynników można wymienić minimum kilkaset. Na ich podstawie Google determinuje nie tylko zakres tematyczny, ale również dopasowanie strony internetowej do oczekiwań użytkownika.

Czytanie danych jest kluczem do sukcesu

Na przykładzie kilku czynników postaram się pokazać korelację, „must have” oraz „should have” w odniesieniu do przykładowej frazy: „prowadzenie fanpage na fb„.

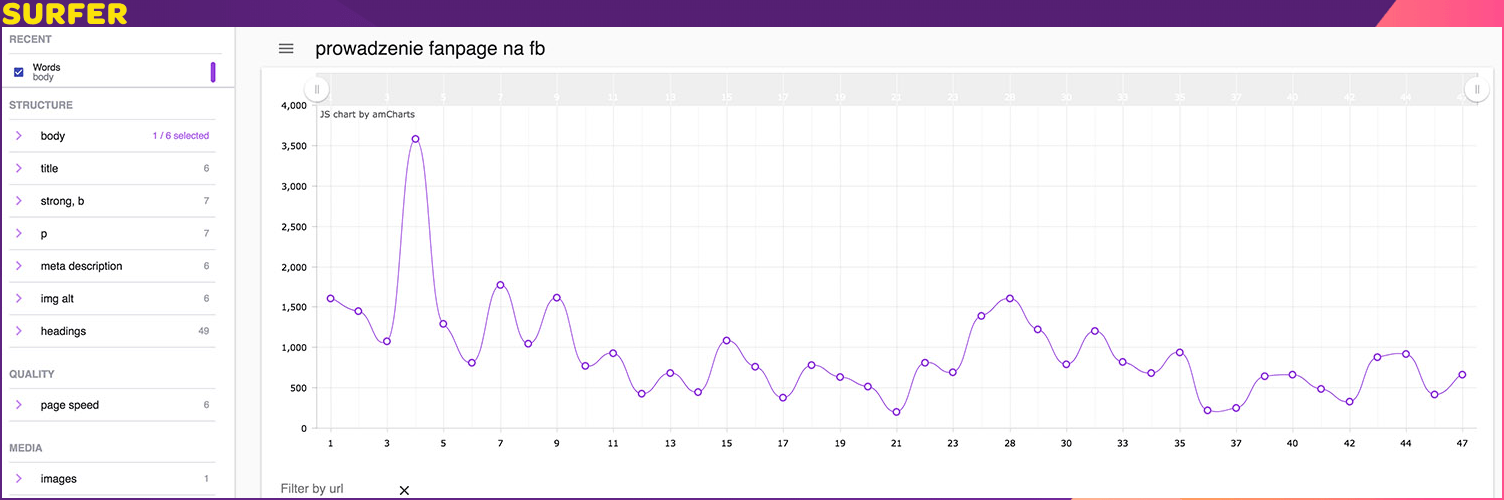

- Obszerność contentu

Ostatnio na jednej z konferencji spotkałem się z komentarzem, że „zawsze im więcej treści tym lepiej”, z czym nie można się zgodzić, ponieważ w obszarach, gdzie użytkownik szuka krótkiej odpowiedzi lub definicji ilość treści nie będzie miała znaczenia lub może działać na niekorzyść.

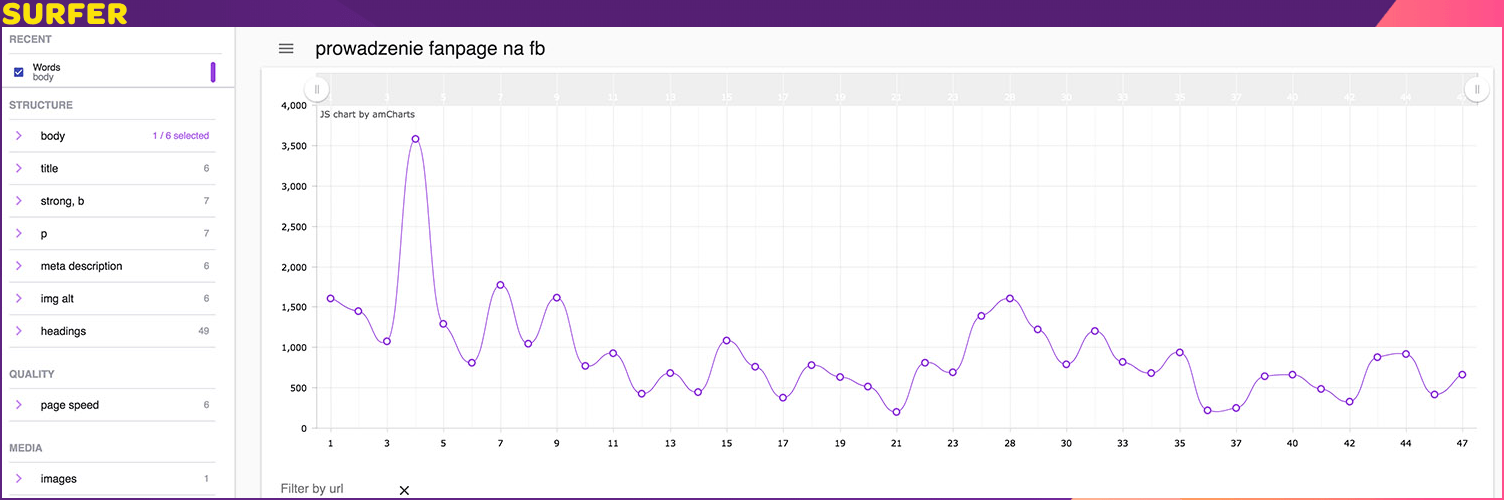

Ilość treści w wynikach organicznych dla top50

Na powyższym wykresie widać, że nie zawsze największa ilość treści jest najlepszym rozwiązaniem, ale jednocześnie można stwierdzić, że osiągnięcie wysokiej pozycji w rankingu dla przykładowej frazy wymaga posiadania znacznej ilości treści na poziomie blisko 1000-1600 słów. Najprawdopodobniej taka ilość jest odpowiednia, aby przekazać potencjalnemu klientowi ofertę, „unique value propositon” oraz zakres cenowy.

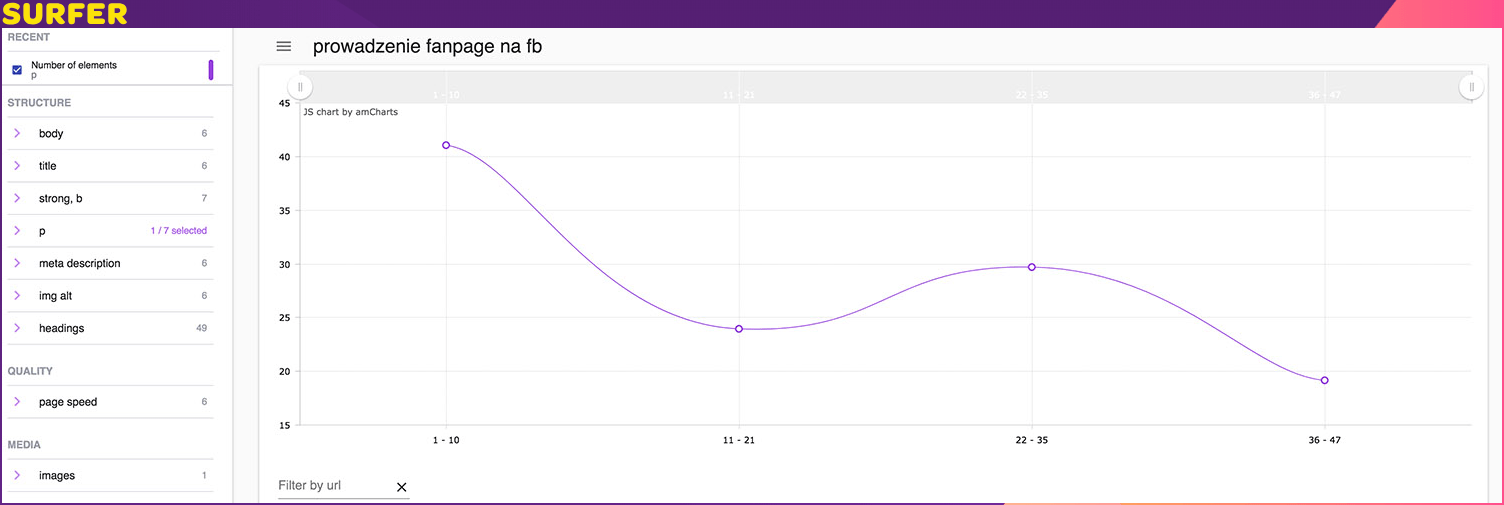

- Ilość obrazków

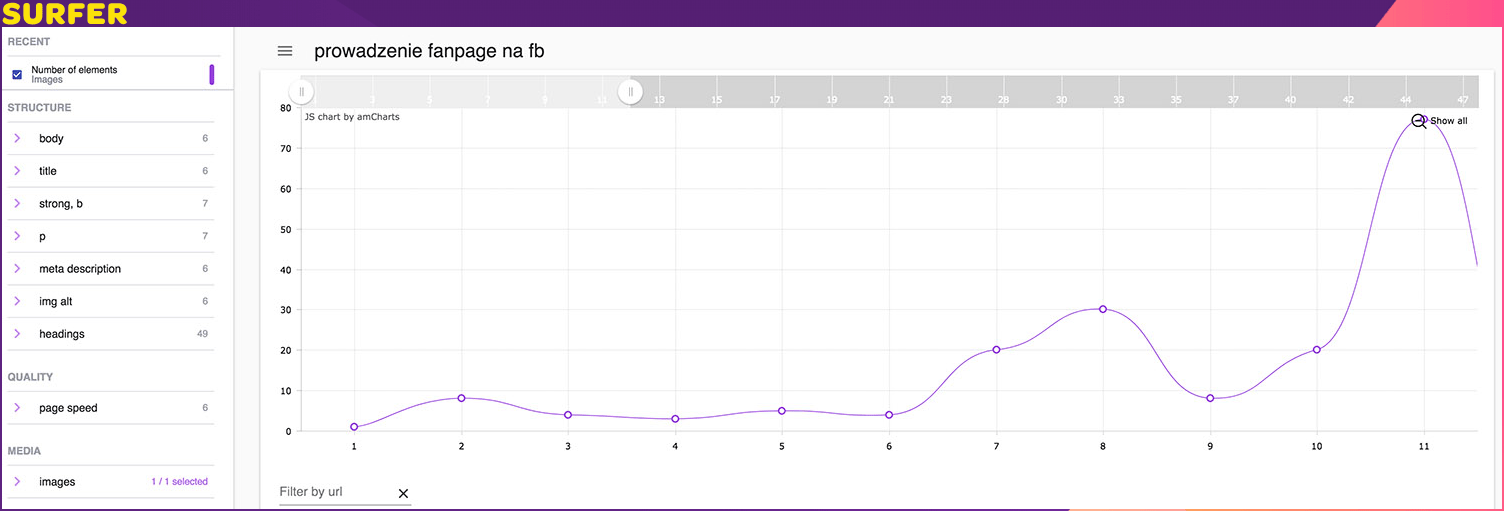

Większość użytkowników to wzrokowcy, dlatego ilość plików graficznych na stronie internetowej musi być duża – sam często łapię się na tym, że biorę to za pewnik. Praktyka pokazuje czasem coś innego.

Ilość plików graficznych w top10 wyników wyszukiwania Google

Okazuje się, że można w tym zakresie przesadzić. Próbując rozwiązać zagadkę dlaczego „sucha” treść jest lepsza, można odnieść się do czasu ładowania strony internetowej. Pliki graficzne wydłużają czas załadowania strony internetowej, który powinien być jak najkrótszy.

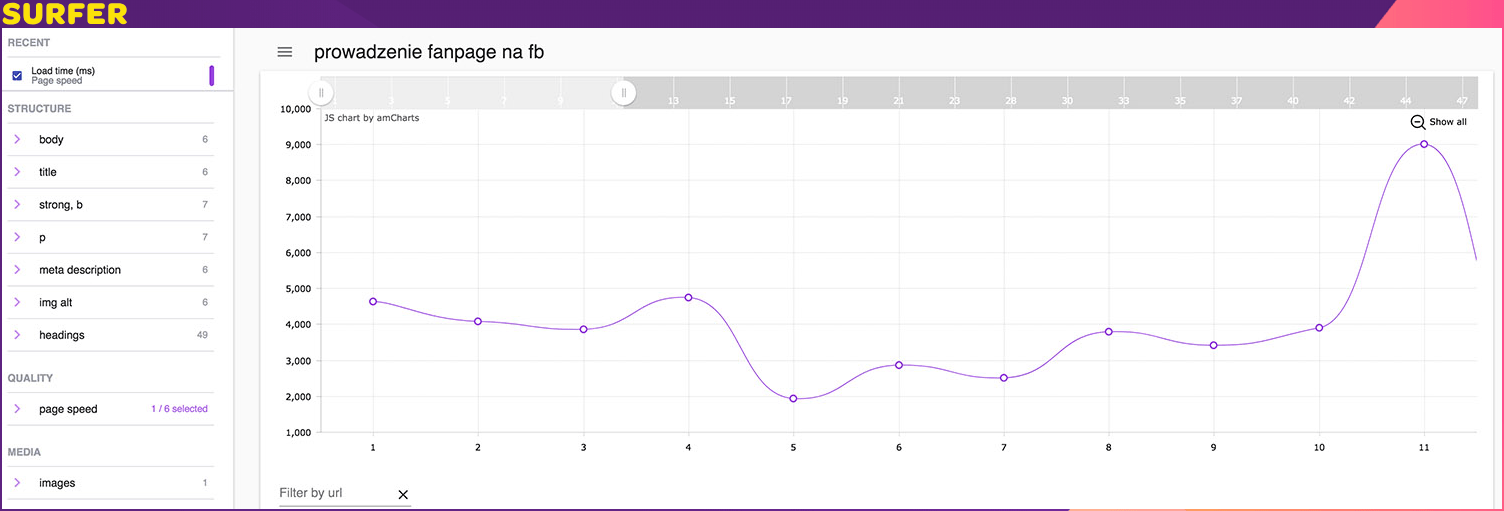

- Czas ładowania strony

Czas ładowania stron w top10 wyników Google

Analizując czas ładowania strony zachęcam do zweryfikowania i porównania wartości TTFB, czyli czasie reakcji serwera po wejściu na Waszą stronę internetową. Rzecz jasna – czas ten powinien być jak najkrótszy. Optymalne wartości TTFB często wymagają dobrej architektury serwerowej, korzystania ze sprawdzonych dostawców i rozwiązań. Ja osobiście używam funkcji porównania TTFB do oceny jakości stron konkurencyjnych.

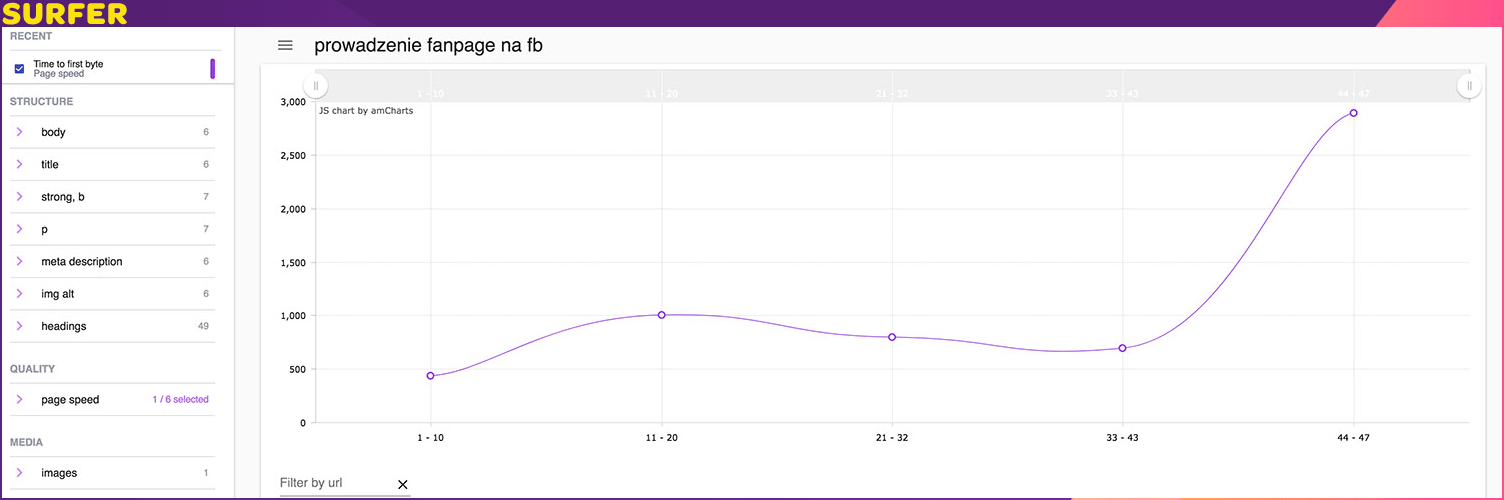

TTFB stron w top50 wyników Google

Średnia dla top 10 wynosi poniżej pół sekundy, co jest dość dobrym wynikiem. Dla porównania średnia wartość dla wyników z drugiej strony Google jest ponad dwukrotnie gorsza.

- Wyniki mają ze sobą wiele wspólnego

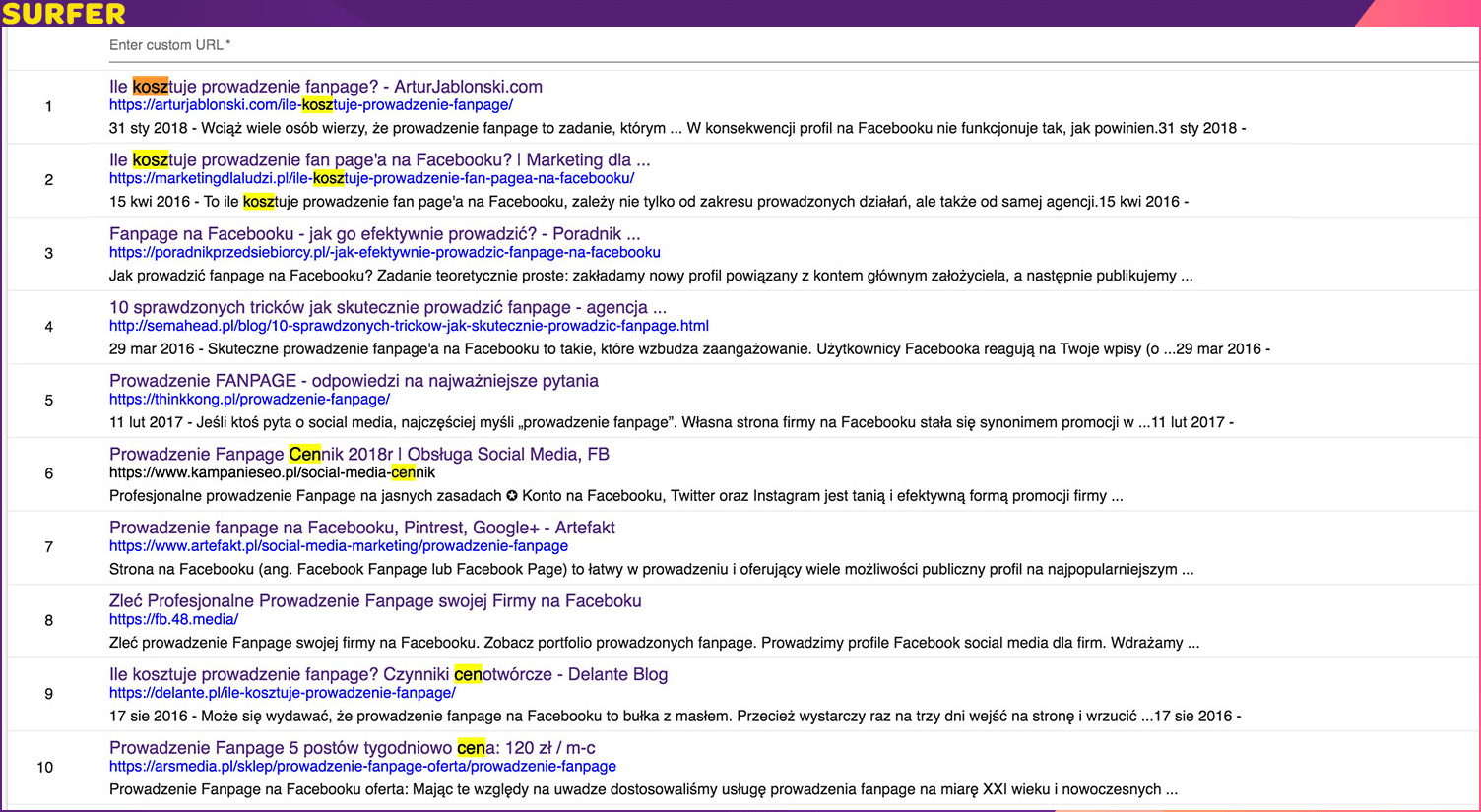

Tak wygląda top10 organicznych wyników wyszukiwania

Zaznaczyłem elementy, które można uznać za wspólne. Większość z wyników zawiera informację o cenie i kosztach. Można więc stwierdzić, że ta informacja jest wartościowa dla użytkownika wpisującego dane zapytanie.

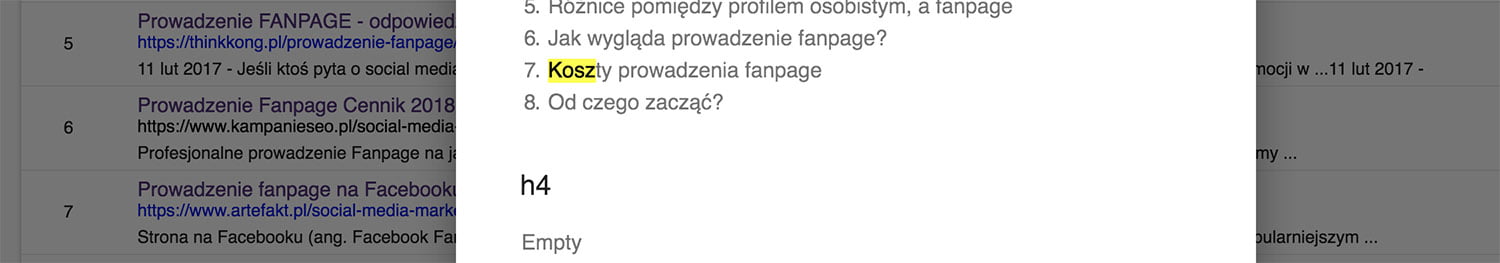

Rozwinięcie opcji „nagłówki” w Surfer

Wyniki, które nie zawierają informacji o cenie w meta tagach – nawiązują do tego elementu w treści i nagłówkach. Dzięki analizie porównawczej można wychwycić wiele innych zależności.

9 na 10 wyników korzysta z certyfikatu SSL

- Akapity

W większości branż da się zaobserwować trend pisania krótkich paragrafów. Z doświadczenia wiem, że lepiej czyta się treść, która jest podzielona i ciekawie ostylowana.

Witryny mające więcej akapitów znajdują się na lepszych pozycjach

- Zagęszczenie słów kluczowych – czyli coś również pod SEO

Jeden z ważniejszych czynników rankingowych potwierdzony wieloma testami, które systematycznie realizujemy.

Słowa kluczowe na stronach w top50

Ilość słów kluczowych (w odmianach przybliżonych) mocno koreluje z rankingiem Google, dlatego pisząc lub optymalizując treść warto zadbać o umieszczenie odpowiedniej ilości.

Jest to również wskazówka dla web developerów. Projektując grafikę warto uwzględnić miejsce, w którym właściciel strony będzie mógł umieścić wymaganą ilość słów kluczowych czy treści . Pozycjonuję strony od ponad 11 lat, sam często łapałem się na tym, że przygotowuję optymalizację „na wyczucie” na bazie doświadczenia. Podejście data-driven jest jednak o wiele bardziej skuteczne. Warunkiem jest oczywiście odpowiedni toolset dopasowany do Waszych potrzeb i wymagań.

Zachęcam do wykorzystania elementów UX, a pośrednio również AI do tego, aby przygotować optymalizację, która będzie nie tylko rankować w Google, ale przede wszystkim spodoba się Waszym użytkownikom.

Poczytaj więcej na naszym blogu

-

Czym różni się backup od archiwizacji poczty?

Archiwizacja poczty to usługa, dzięki której Twoje wiadomości są archiwizowane nawet gdy zostaną usunięte z serwera. Backup natomiast służy jedynie do przywracania danych po awarii, umożliwiając kopiowanie zestawów danych z kopii zapasowej. -

Jak zainstalować Moodle? Poznaj platformę e-learningową do zdalnego nauczania

Moodle – to narzędzie wychodzące naprzeciw edukacji zdalnej. Moodle przeznaczone jest do przeprowadzania zajęć, kursów czy innych aktywności na odległość.